部署本地大模型可参考《Windows本地部署DeepSeek R1大模型》

1、依赖

如果是调用本地ollama部署的大模型,需要使用如下依赖:

<!--LangChain4j 针对 ollama 的 Spring Boot starter-->

<dependency>

<groupId>dev.langchain4j</groupId>

<artifactId>langchain4j-ollama-spring-boot-starter</artifactId>

<version>1.10.0-beta18</version>

</dependency>

若调用的是外部大模型,则使用如下依赖

<!--LangChain4j 针对 open ai 的 Spring Boot starter-->

<dependency>

<groupId>dev.langchain4j</groupId>

<artifactId>langchain4j-open-ai-spring-boot-starter</artifactId>

<version>1.10.0-beta18</version>

</dependency>

2、配置

配置把open-ai换成ollama即可,open-ai是调用外部模型时使用。

langchain4j:

#open-ai:

ollama:

chat-model:

base-url: http://192.168.2.131:11434

#api-key: 12345

model-name: deepseek-r1-1.5b

3、实例代码

/**

*

*/

package cn.lovecto.yuen.agents.controller;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

import cn.dev33.satoken.annotation.SaIgnore;

import dev.langchain4j.model.chat.ChatModel;

@SaIgnore

@RestController

public class ChartController {

@Autowired

private ChatModel chatModel;

@GetMapping("/chat")

public String model(@RequestParam(value = "message", defaultValue = "Hello") String message) {

return chatModel.chat(message);

}

}

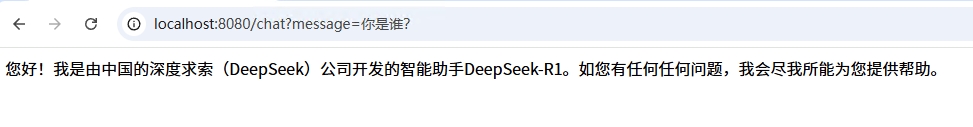

运行后,访问如图:

LoveCTO

LoveCTO